- ReLUの原点での急な変化を, 2次関数で補完することでスムーズにした活性化関数 SmeLU (Smooth ReLU)を提案

- リコメンデーションシステムにおいては, 再現性の低さは致命的となる

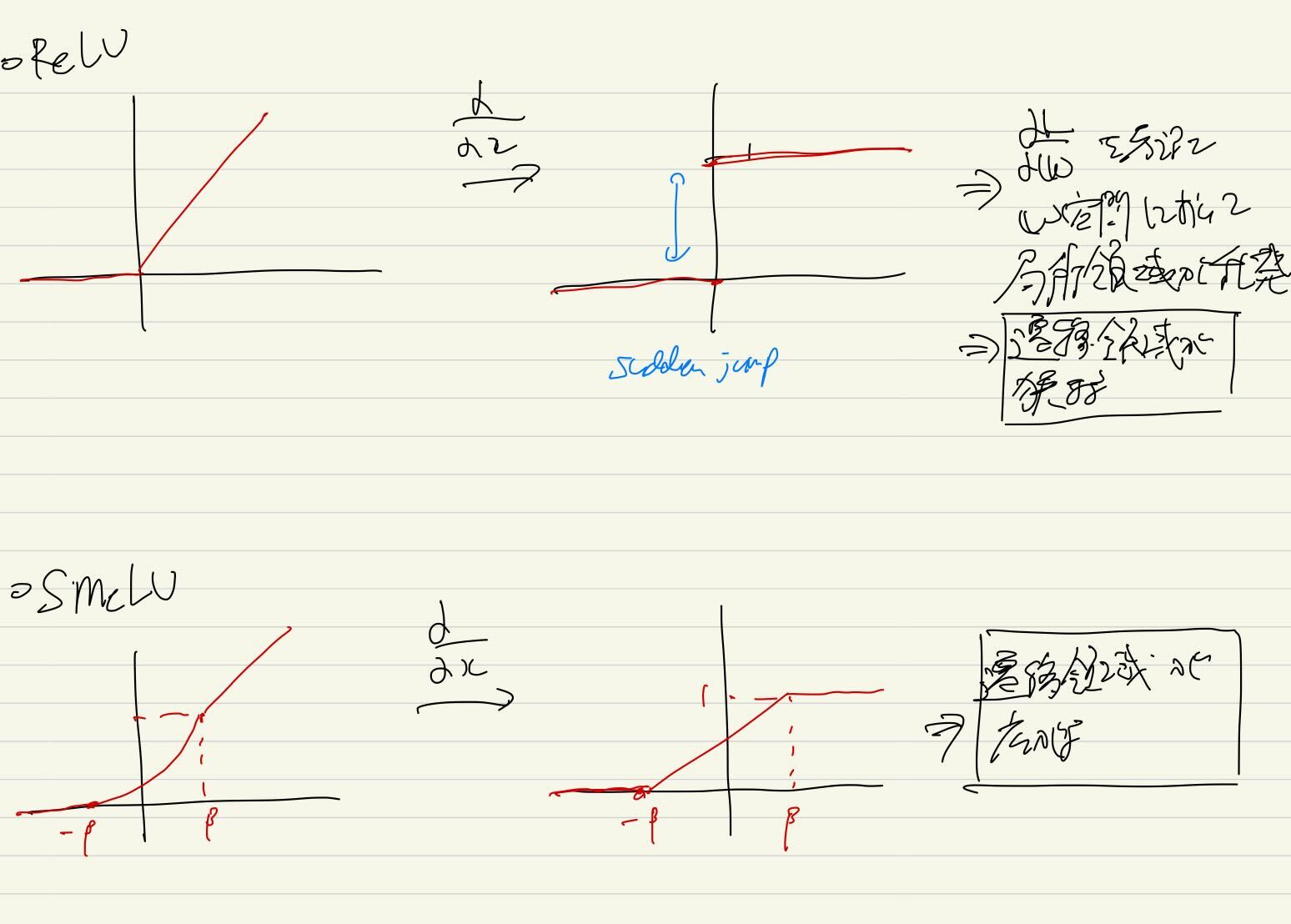

- ReLU は勾配がジャンプするので(sudden jump), 損失平面に局所領域ができてしまう

- そのため, 遷移領域が狭まる

- 遷移領域が狭まってしまうと局所的な遷移しかしないので, モデルの様々なランダム性によって, 遷移方向がだいぶ異なってしまう

- そこで, 勾配が連続になるような活性化関数SmeLUを提案

- ただし, 遷移方向が広がった分, 精度は落ちる

- → 遷移方向が広がることで, 行っちゃうところまで行ってしまうため (だと思う)

- ⇒ 精度 vs 再現性 をハイパラ $\beta$で調整

→ $\beta$は二次関数の間隔を決める