-

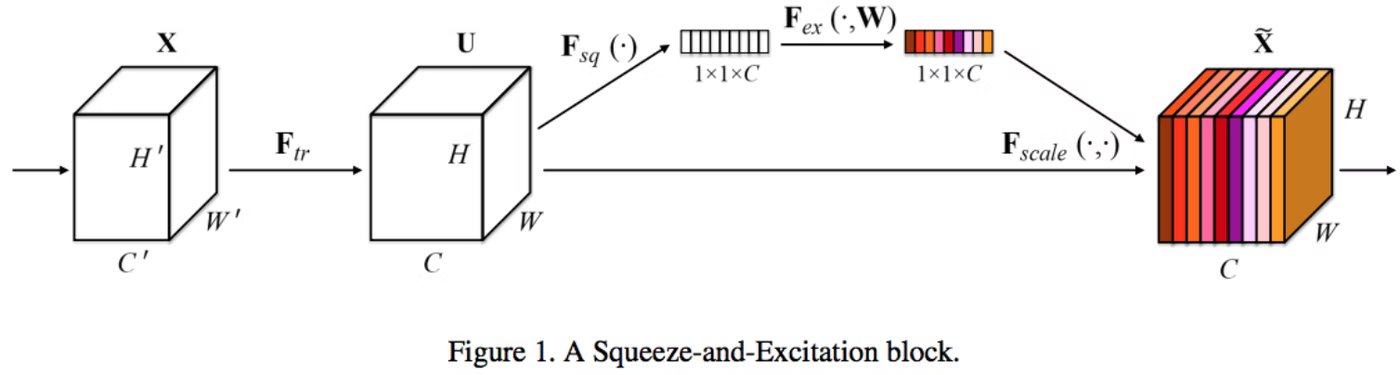

Squeeze

- Global Average Poolingで各チャネルの平均 $z$を取る

- チャネル数を少しだけ減らす

-

Excitation

- 各チャネルについて, 平均 $z$から元の次元に戻す

- ↑チャネルごとにこいつで重み付け

-

何が嬉しいの?

-

空間方向だけでなく, チャネル方向の関係を捉えることが出来る

- 例えば, ある特徴マップと別の特徴マップとで同じような部分に強い反応があれば, それらの関係を強めることが出来る

- ということは, 価値の高い特徴マップを炙り出せるということっぽい?

-

計算量軽くて有効らしい

-

このブロックを追加したとしても、計算量は1%以下しか増加せず、様々な既存モデルに適用できることが特徴ということです。例えばResNet-50に適用することで、ResNet-101相当の性能になり、ResNet-101に比べて半分の計算量になることが利点となります。

https://qiita.com/daisukelab/items/0ec936744d1b0fd8d523

- Self-Attentionと同じような効果があるらしい?

画像全体の情報を利用するTransformerのSelf-Attentionのような効果があるという見方が強くなっています。