【論文メモ】Maximum Classifier Discrepancy for Unsupervised Domain Adaptation

· ☕ 1 min read

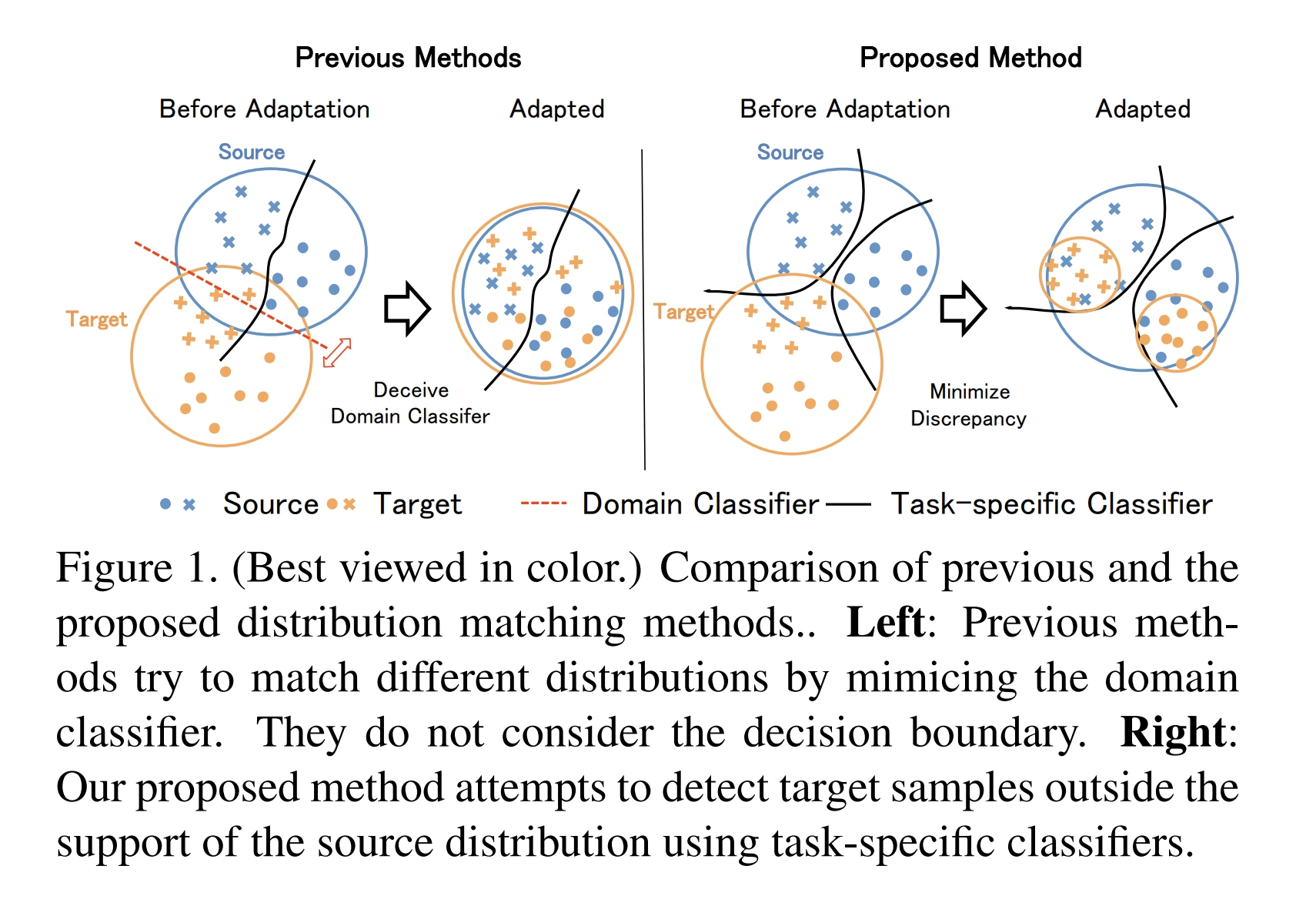

Domain Adaptation 従来手法 : sourceとtargetとで分布が違うはずなのに, ドメイン同士の境界(赤線)を基準に近づけようとしている → 分布の違いを考慮しつつ決定境界を修正する必要がある → GAN GAN風に学習する 2つのclassifierとそれらを生成するgenerator ...