はじめに

- ECCV22のbest paper

#ECCV2022 Paper Awards pic.twitter.com/u9awGVCgSr

— European Conference on Computer Vision (ECCV) (@eccvconf) October 27, 2022

概要

-

二つのモデルの挙動を比較することは極めて重要

- しかし, それぞれが異なるアーキテクチャにおけるモデルの比較方法は依然として研究が不十分.

-

そこで, この論文では(Partial) Distance Correlationを機械学習に応用する手法を提案.

-

(Partial) Distance Correlationを用いることで様々な応用が期待される.

-

論文中では以下の3つが提案されている.

- モデルの条件付け

- 敵対的サンプルへの防御

- Disentangledな表現の学習

-

(Partial) Distance Correlationについては

- 輪講スライド

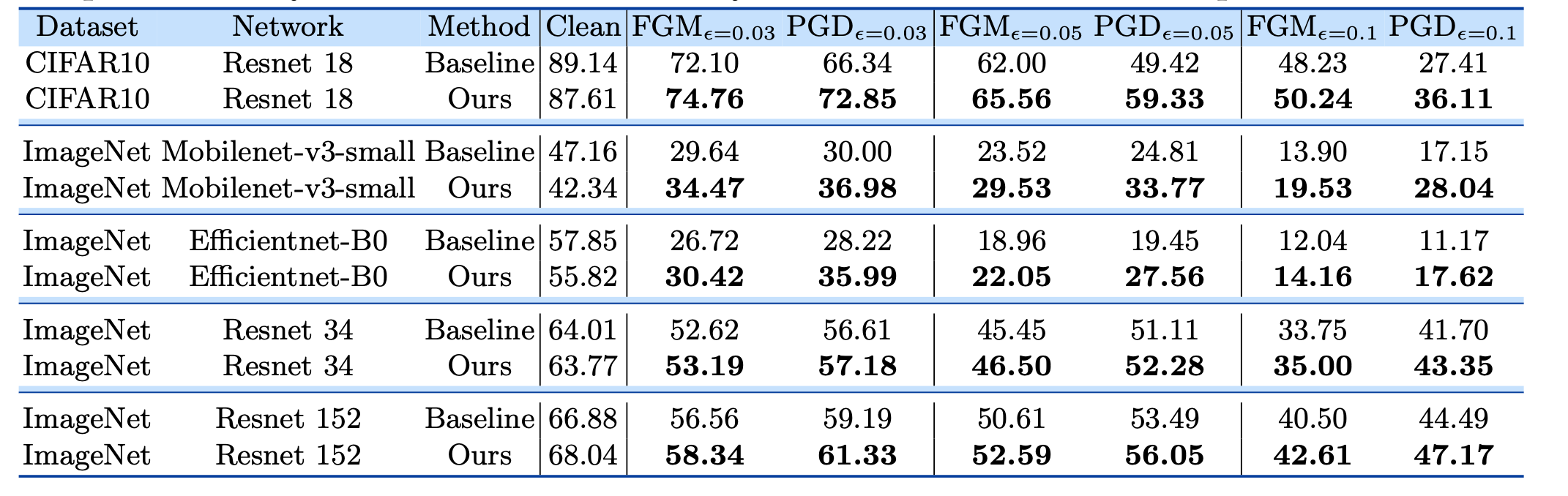

敵対的サンプルへの防御

- あるモデルXにおいて有効な敵対的サンプル

- したがって, 二つのモデル

- そこで, 以下のような損失を定義

-

ここで,

-

結果は以下の通り.

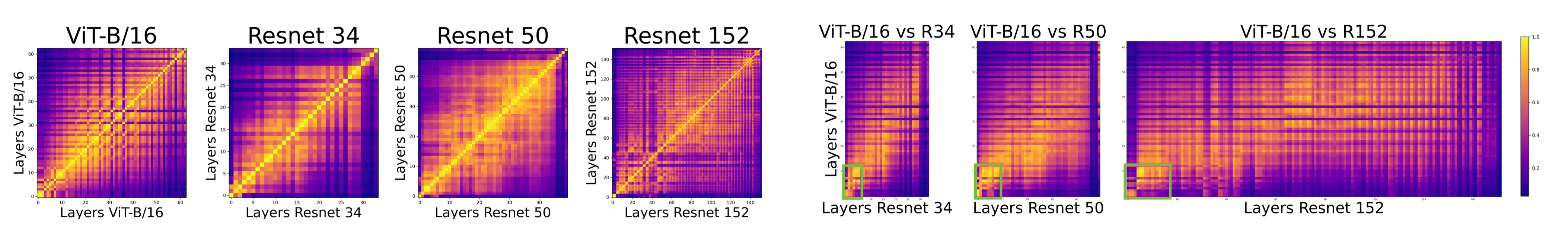

モデルにおける情報量の比較

-

Distance Correlationは出力の次元に依存しないので, 異なるアーキテクチャのモデル同士を比較することが可能

-

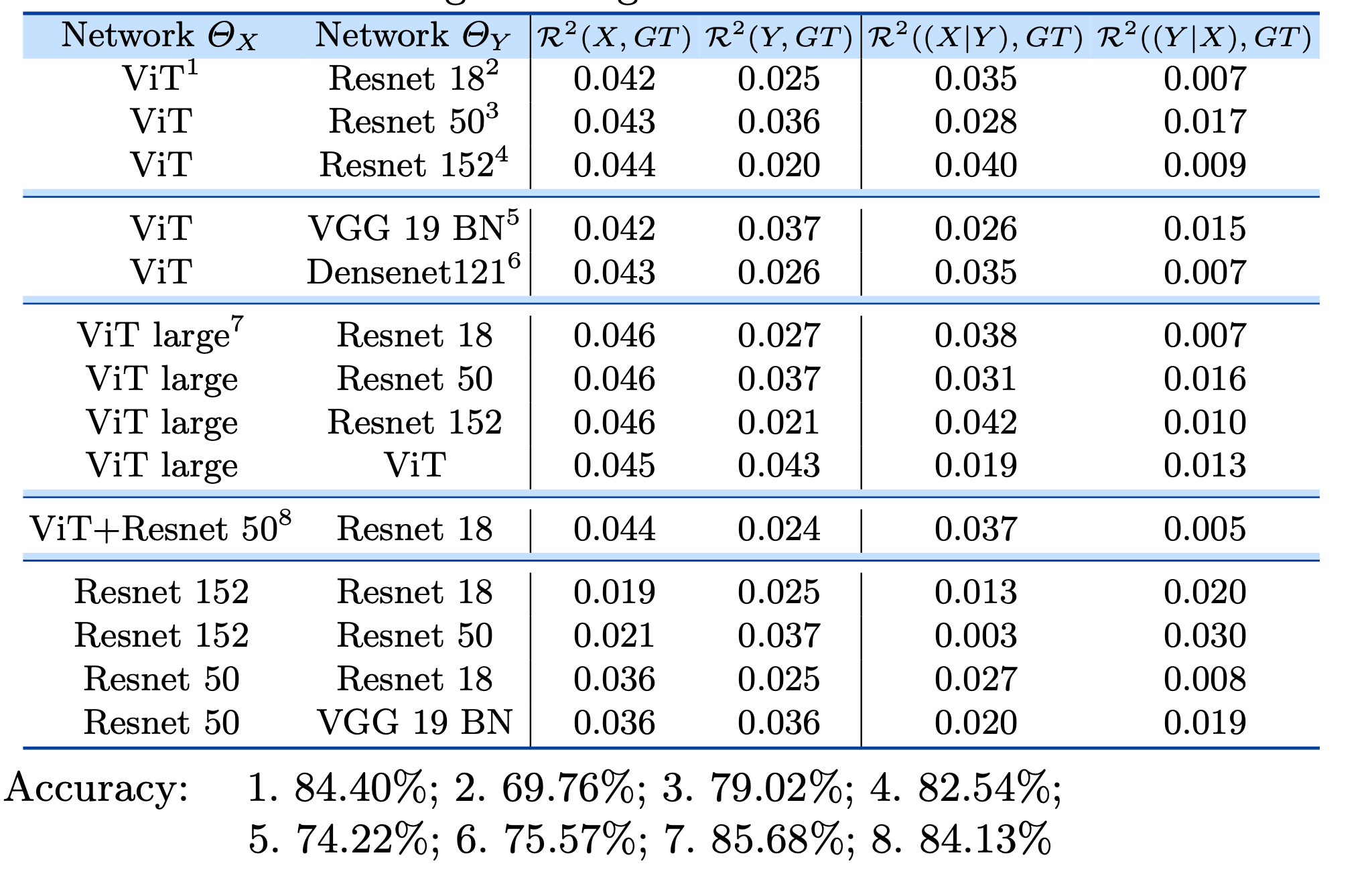

さらに, Partial Distance Correlation(PCD)を用いることで, 「モデルYが学習した情報」以外にモデルXが何を学習しているのかを推測することができる.

-

例えば,

-

ここで, 「Yで条件付けされたX」とは「Yを前提とするX」に等しいので, 要はモデル

-

GTにはclass名をBERTに通した出力を使用.

- one-hotベクトル等でも良かったが, ベクトル同士の関係性が皆無なのでBERTを採用.

-

モデルYが学習した情報とは異なる情報をモデルXに学習させるために, 以下のような損失を定義

- X, Yをpretrainした後に, Xのみ以下の損失でfine-tuning

-

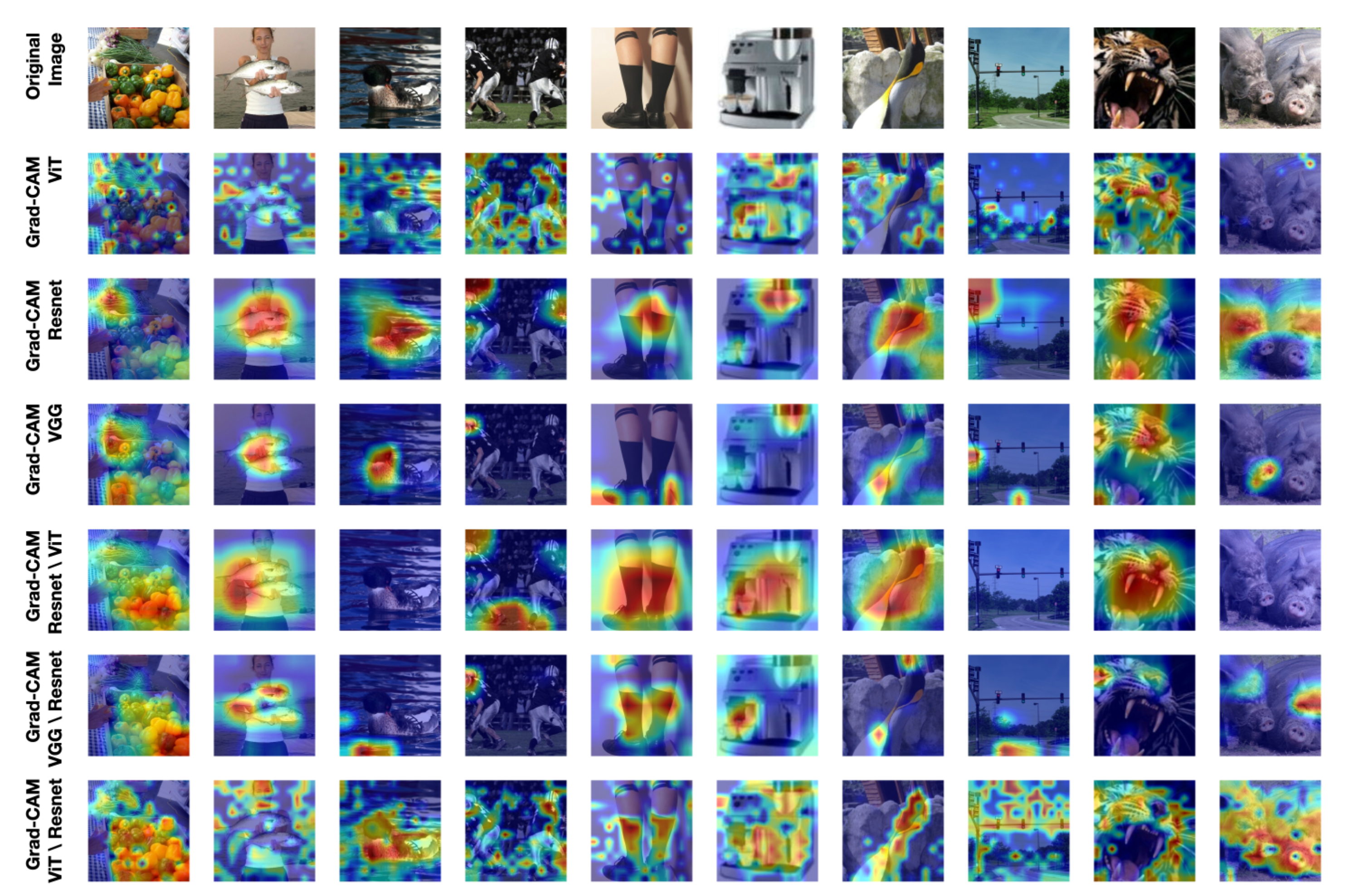

- 以下の図はGradCamを用いてモデル

- ViT \ ResNet を見ると, より被写体に注目していることから, ViTはResNetでは捉えられない細かい領域を捉えている可能性が示唆される.

- ViT \ ResNet を見ると, より被写体に注目していることから, ViTはResNetでは捉えられない細かい領域を捉えている可能性が示唆される.

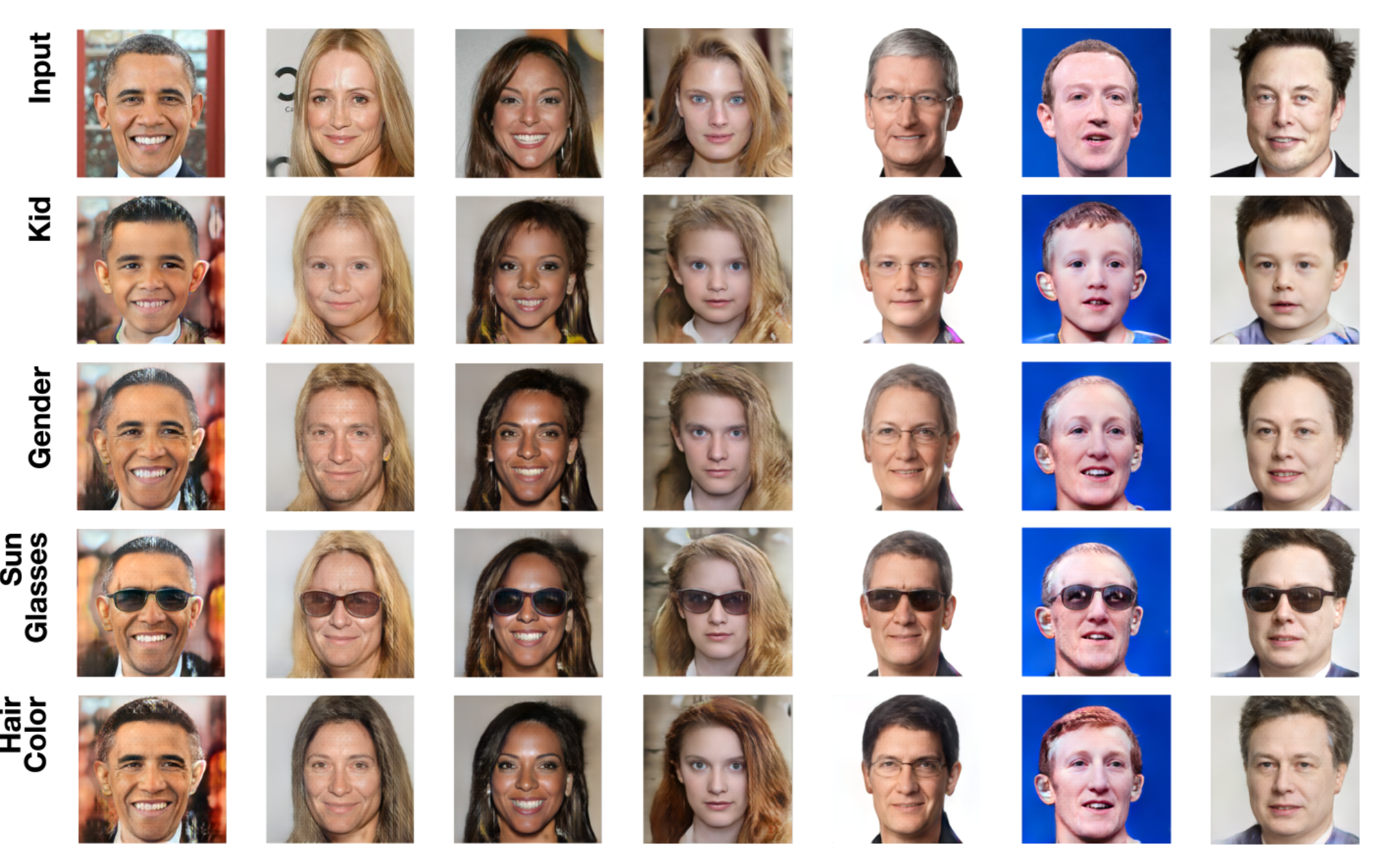

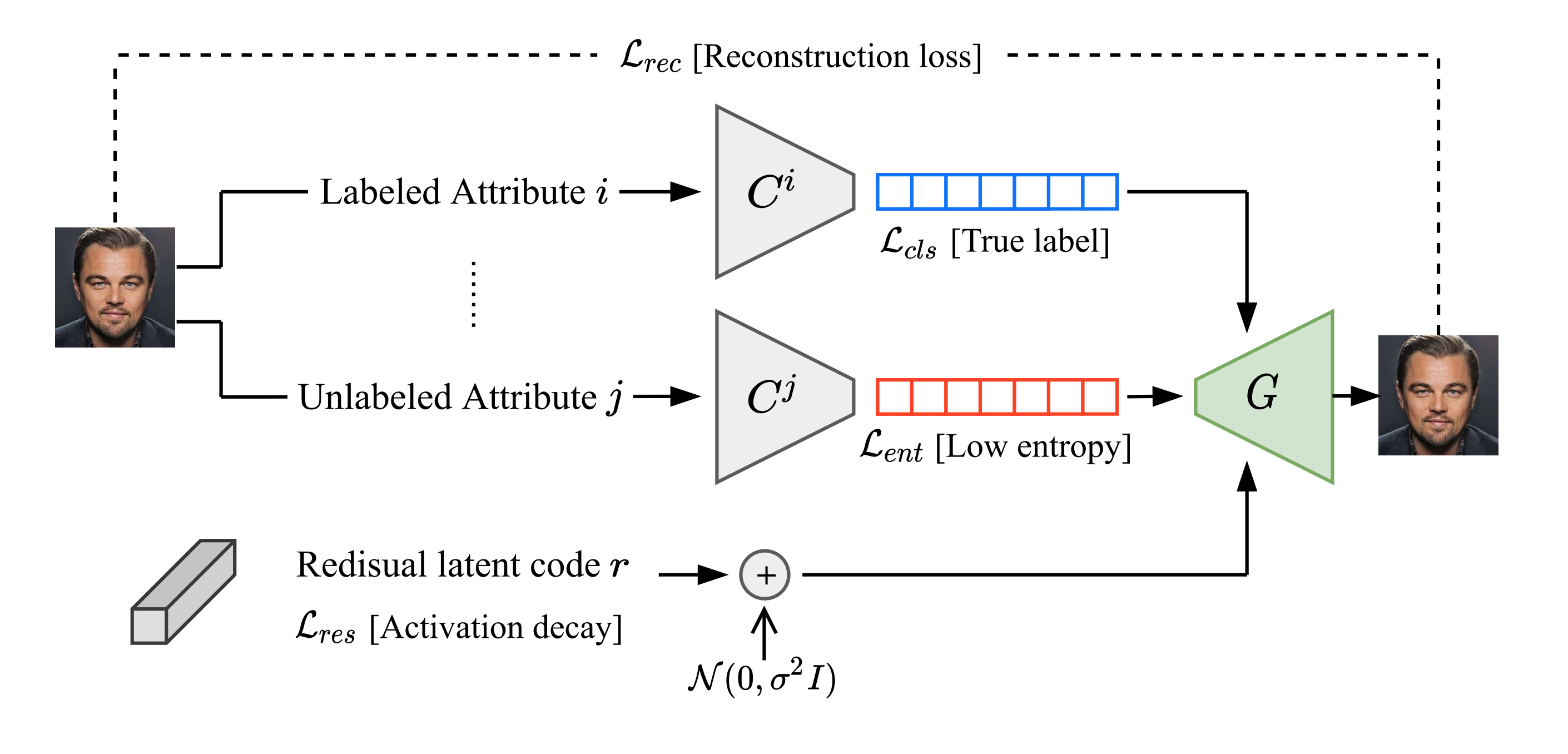

Disentanglement

- GeneratorにStyleGAN2を使い, (Gabbay+, NeurIPS21)の要領で学習

- データセットはFFHQ

- (Gabbay+, NeurIPS21)での本来の損失

- 本論文では属性

(Gabbay+, NeurIPS21)