【論文メモ】Energy-Based Learning for Scene Graph Generation

· ☕ 3 min read

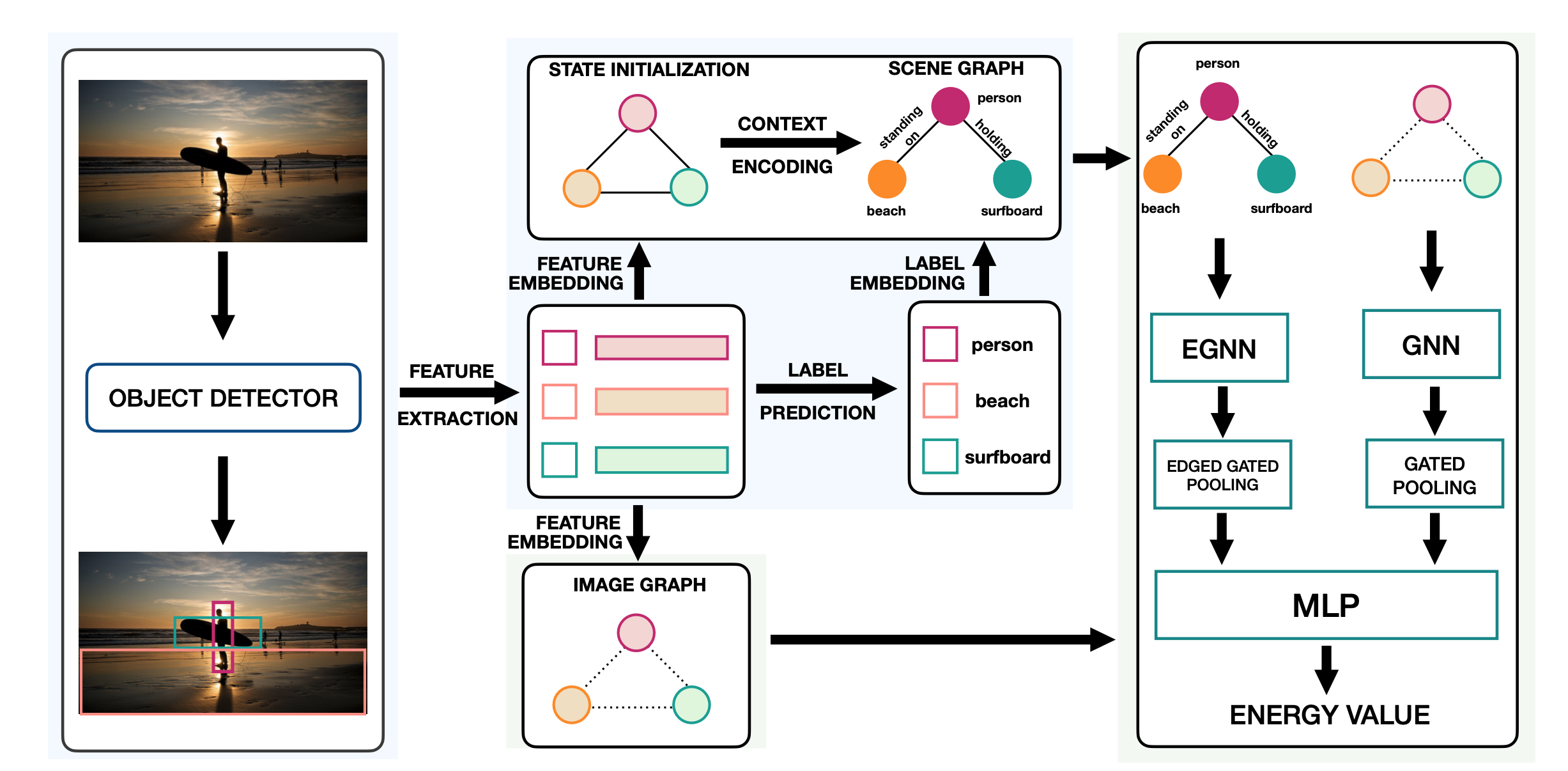

はじめに Energy Based Modelを用いて画像からscene graphを生成する手法(フレームワーク)を提案 既存手法は次のようにクロスエントロピーでscene graphを生成する