【論文メモ】Graph Transformer: A Generalization of Transformer Networks to Graphs

· ☕ 1 min read

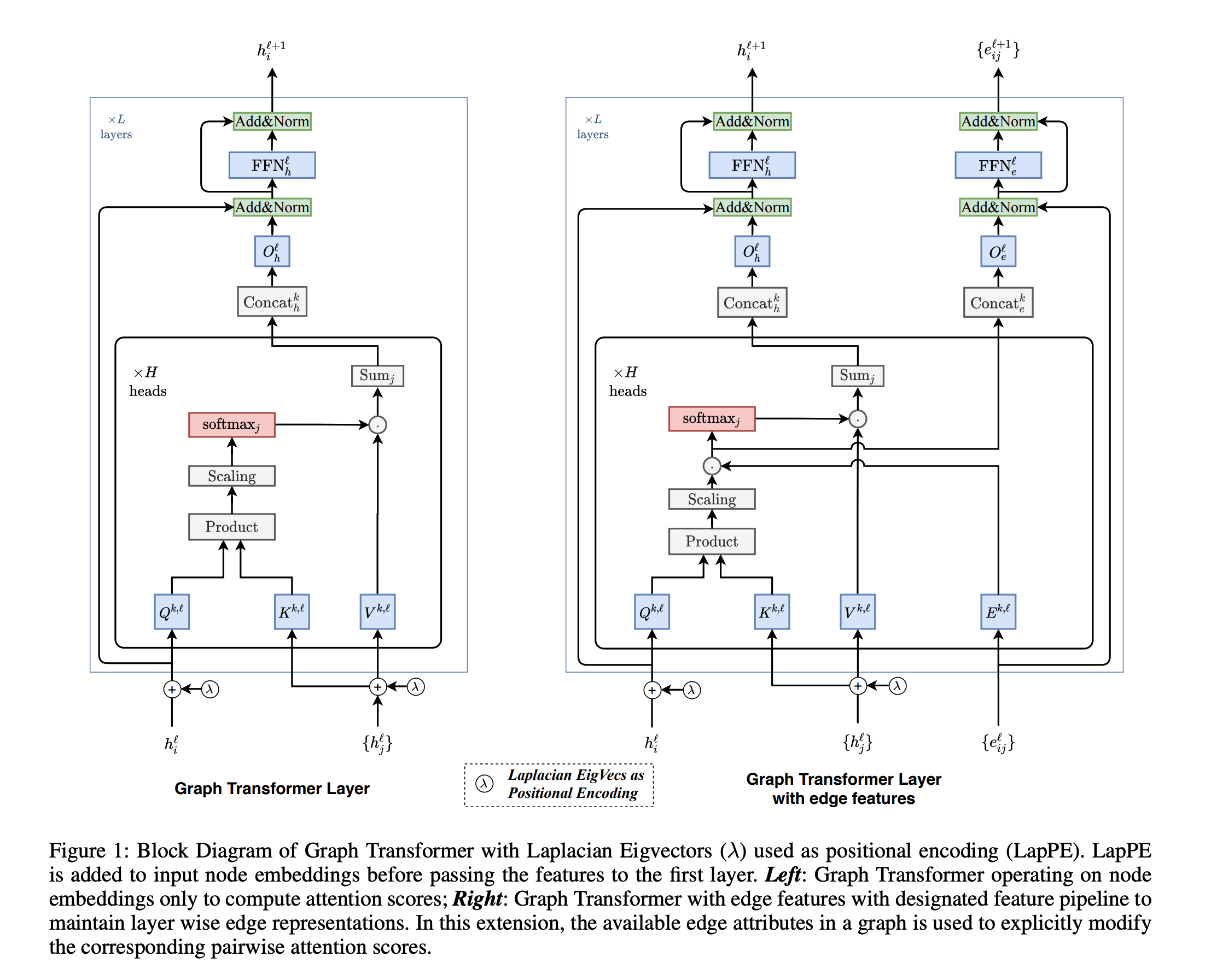

任意のGraphに適応可能な, 汎用Transformer Positional Encodingがラプラシアン行列の固有値で表現される ラプラシアン行列の固有値 $\lambda$は頻度・周波数的な側面を持つ → グラフ上のフーリエ変換・畳み込みでは $\lambda$が使われる (いつかまとめる→todo) todo https://arxiv.org/pdf/2012.09699v2.pdf ...