-

PMLR20

-

trainとtestで分布が違う場合の再学習手法TTT(Test-Time Training)を提案

- まずは普通に学習

- 次にモデルを前半(A)と後半(B)に分けて, 元のA + 新しいB’ のモデルで自己教師あり学習を行う

- headを取っ替えるイメージ (B→B')

- このとき, testサンプルを使用して自己教師あり学習を行う

- こうすることで, ラベルを見ずにモデルの出力分布をtestに近づけることができる

- ラベルは見ていないので, leakageとは呼ばない (と主張している)

-

(これってホントに大丈夫なのか…? leakageとまでは言えなくても, testを一回見たことある状態って若干マズくないか)

- と思ったが, どうやらこの手の手法は古くからある伝統的なもので, transductive learningなどと言うらしい

- なるほど, 下の引用を見るに, 問題設定の根本から違うものらしい

- 実運用上どのようなユースケースが考えられるのだろうか🤔

Inductive learning is the same as what we commonly know as traditional supervised learning. We build and train a machine learning model based on a labelled training dataset we already have. Then we use this trained model to predict the labels of a testing dataset which we have never encountered before.

In contrast to inductive learning, transductive learning techniques have observed all the data beforehand, both the training and testing datasets. We learn from the already observed training dataset and then predict the labels of the testing dataset. Even though we do not know the labels of the testing datasets, we can make use of the patterns and additional information present in this data during the learning process.

引用: https://towardsdatascience.com/inductive-vs-transductive-learning-e608e786f7d

- 自己教師ありの学習方針として, MAEを用いた論文がNeurIPS22に通っている… (ビックリ)

- Test-Time Training with Masked Autoencoders

- https://arxiv.org/abs/2209.0752

- よくみたらFAIRの人とかいるし, 割とちゃんとした論文なのかも (失礼)

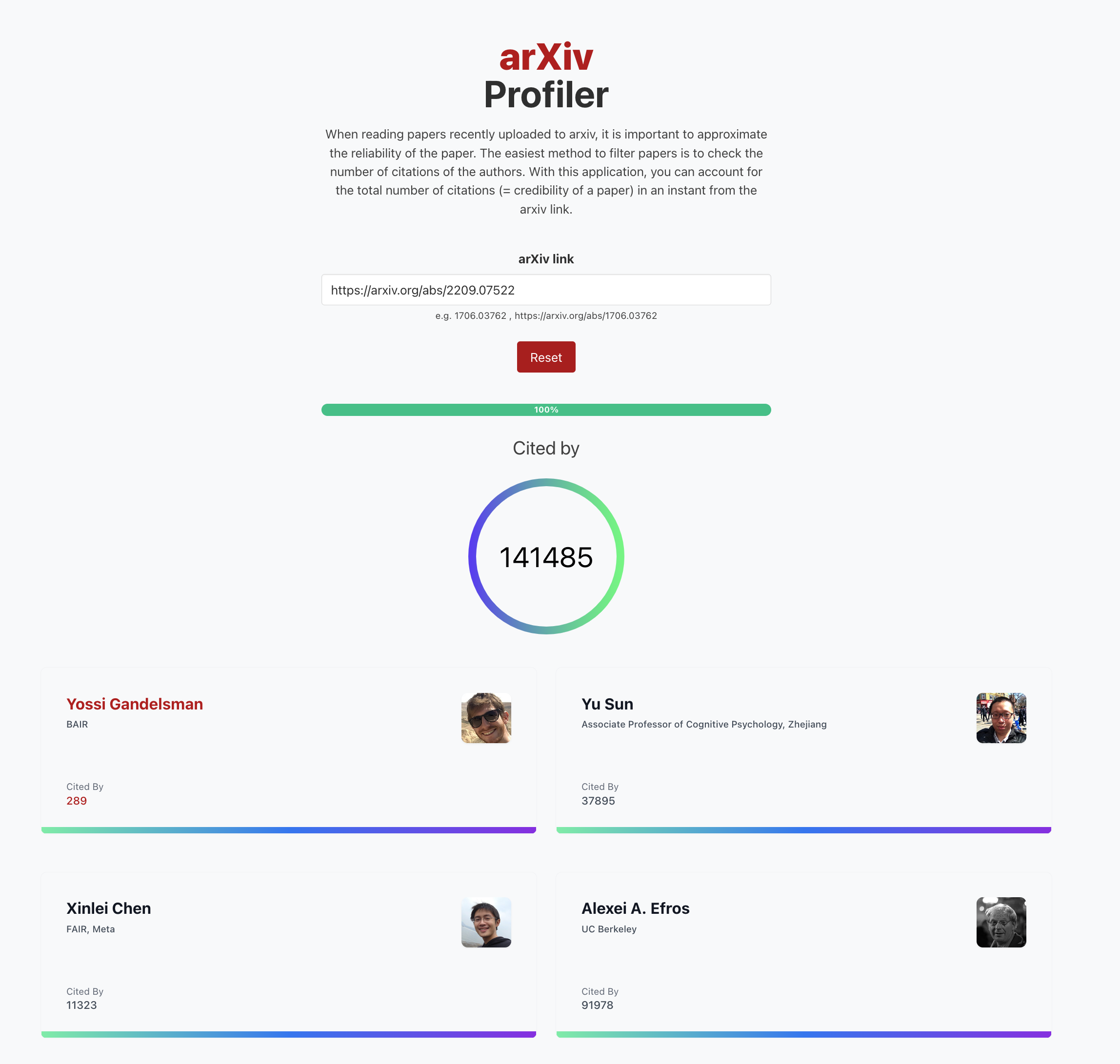

- と思ったら, やっぱり普通に信頼して良さそうな方たちでした… by arXivProfiler