-

1つ目: NNは高周波数成分の学習に弱い

- なので, 飛び値的なデータに弱い

- 一方決定木ベース手法は領域を長方形に区切ってるだけなので飛び値的なデータに強い

- 詳しくは拙作→決定木をフルスクラッチで書けるようになろう (CART)

- NeRFやPerceiver: General Perception with Iterative Attentionと同じこと言ってる

- 実験: ガウシアンフィルタを掛けて平滑化することで飛び値の影響を比較

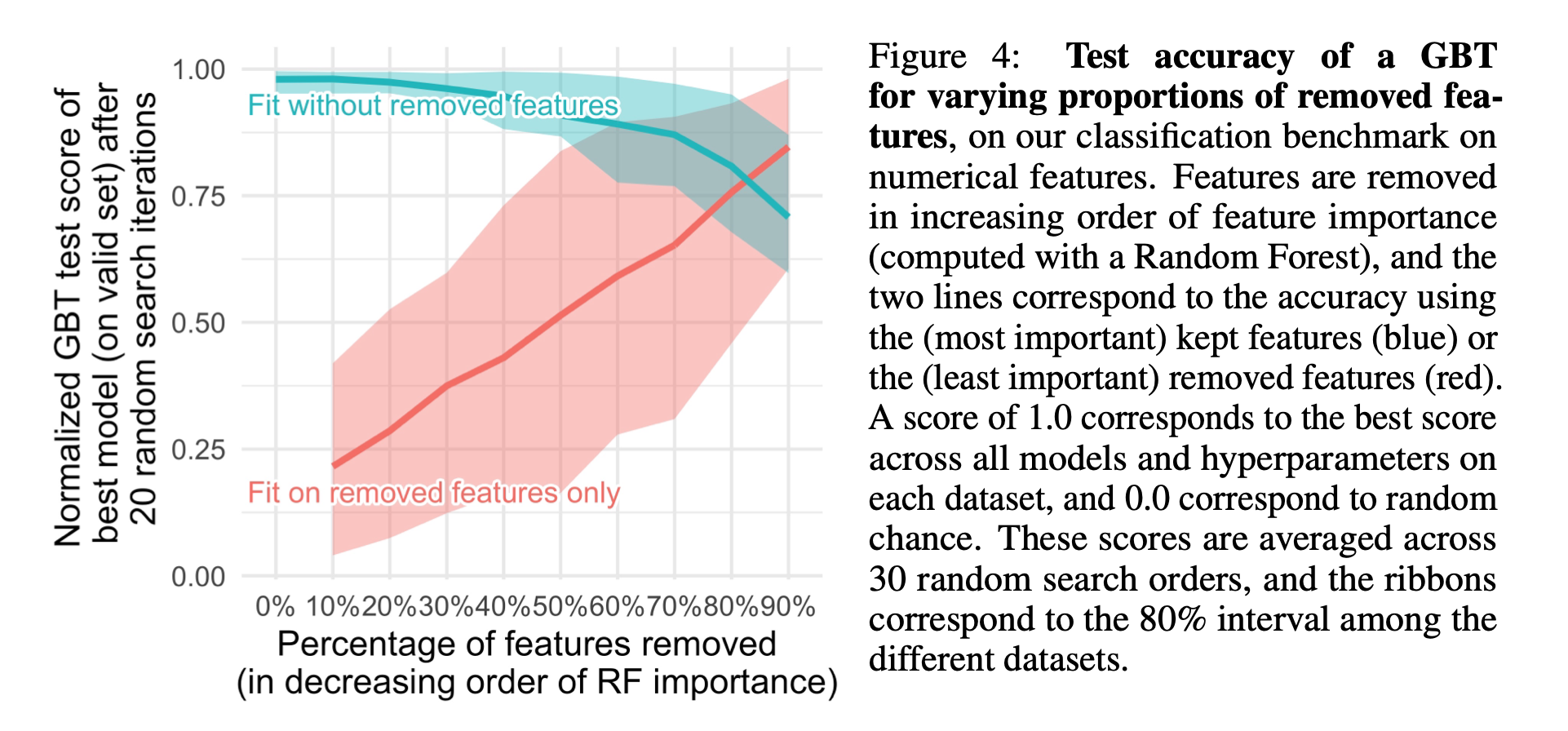

- 2つ目: MLPは不必要な情報に弱い

- 実験: ランダムフォレストで得られた特徴量の重要度を元に特徴を少しずつ削除して結果を比較

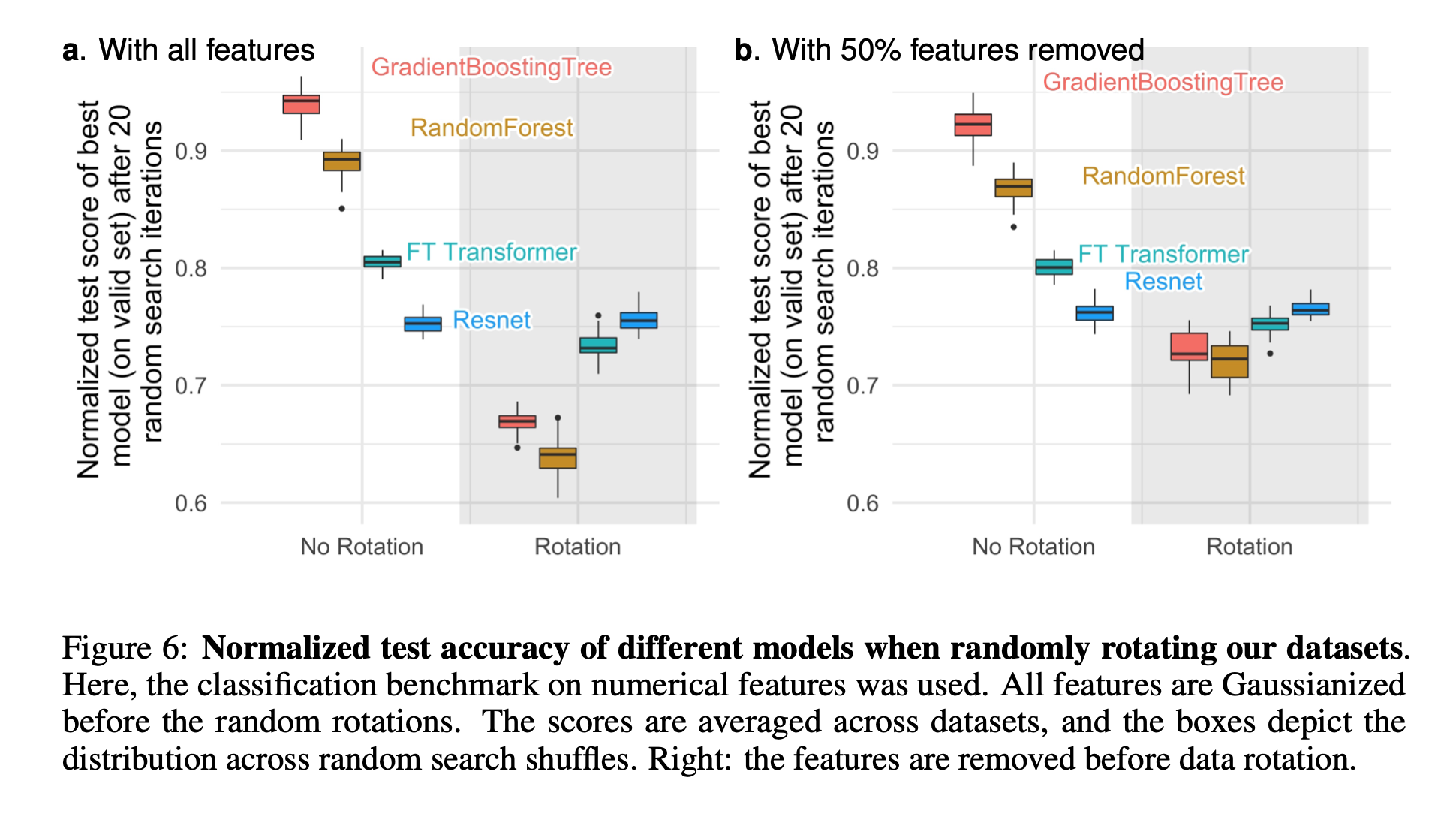

- 3つ目: テーブルデータは回転不変性を持たないので, NNの学習は向かない

- NNは回転不変性を持つ. すなわち, 任意のユニタリ行列を掛けて入力してもほとんど出力に影響がないように学習される

- 実験: 回転を掛けたバージョンとそうでないものを比較

- 下図を見ると, 回転を掛けることで順位が逆転している(NN > Tree-based)